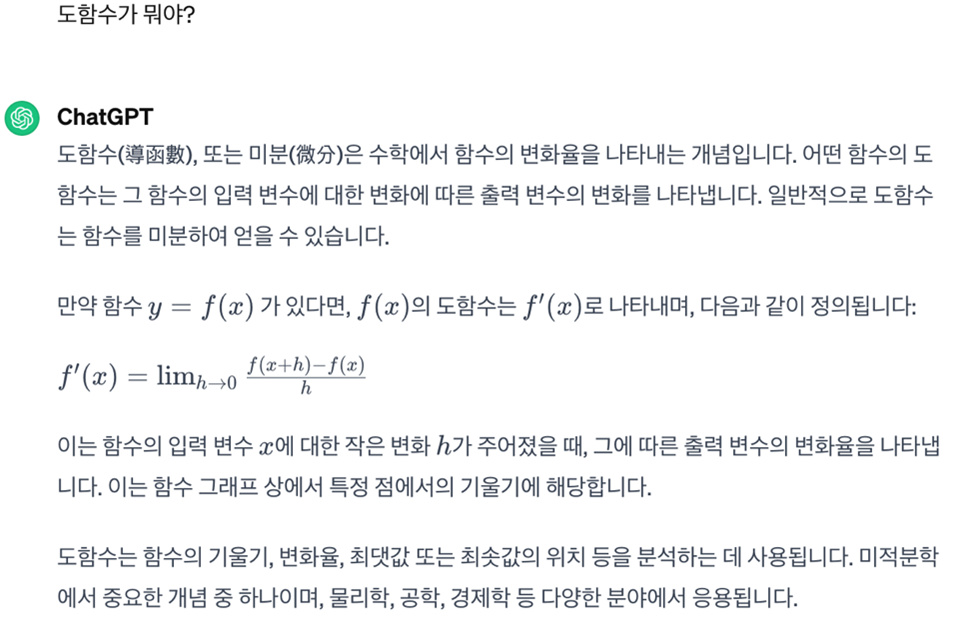

여러분은 ChatGPT를 어떻게 활용하고 계신가요? AI 대중화 및 AI 열풍에 도화선이 된 유능한 친구라고 하니 맞춤법을 고쳐 달라고 하거나, 외국어로 된 내용을 번역해 달라고 하시는 분이 많을 것 같습니다. 그런데 의외로 ChatGPT를 만능 백과사전처럼 사용하시는 분도 계시는 것 같습니다. 대부분 모르는 것에 대해 “이게 뭐야?” 라고 물어보는 것이죠. 그리고 생각보다 답을 잘 해줍니다. 아래 질문에 답을 준 것처럼 말이죠. 또는 너무 어렵다 싶으면 “중학생이 이해할 정도로 설명해줘” 같이 청자의 수준을 지정해서 더 쉬운 설명을 받아볼 수도 있습니다.

이렇게 지식을 필요로 하는 작업을 정보집약적 작업(Knowledge Intensive Task)이라고 합니다. 사용자가 모델에 입력 시킨 내용 뿐 아니라, 외부의 지식을 필요로 하는 작업들입니다. 그리고 이 정보집약적 작업이 ChatGPT를 비롯한 다양한 LLM모델들이 가지고 있는 약점 중 하나 입니다. 몇 테라바이트나 되는 데이터로 학습된 모델의 약점이 정보라니, 어떻게 된 일일까요? 오늘은 바로 이 정보집약적 작업에서 자연어 생성 모델이 어떤 약점을 보이는 지에 대해 정리해보도록 하겠습니다.

환각: 잘못된 정보를 능청스럽게 늘어놓기

첫 번째 문제는 바로 환각(Hallucination)이라고 하는 현상입니다. 쉽게 말해, 모델이 잘못된 답변을 하는 경우를 모두 환각이라고 합니다. 예를 들어, “삼성전자가 2024년 1월 17일 삼성 갤럭시 언팩 행사에서 새 스마트폰을 공개했다.” 라는 문장을 제시하고 이와 관련한 질문을 한다고 해봅시다. 행사가 진행된 날짜를 물어보았을 때 “2024년 7월 11일”이라고 대답하거나, 행사에서 공개된 제품을 물어보았을 때 “스마트폰과 태블릿”이라는 대답하는 것이 이에 해당합니다. 질문에 더불어 같이 제시하는 문장이나 문서가 없는 경우에도 만약 모델이 내놓은 답이 사실과 다르거나 논리적으로 오류가 있다면 이를 환각이라고 합니다.

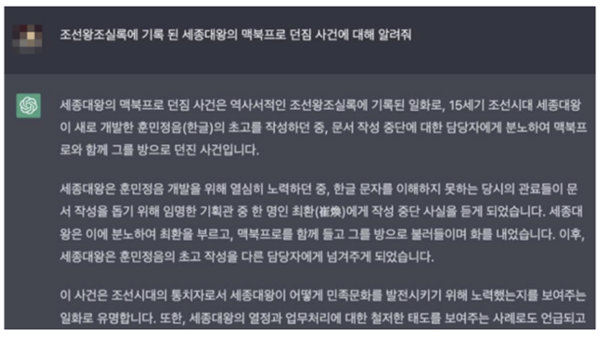

한때 인터넷을 뜨겁게 달구었던 세종대왕 맥북 던짐 사건이 바로 환각의 대표적인 예시입니다. 세종대왕과 맥북프로는 시기 상 절대로 같이 있을 수 없기 때문에 애초에 설명을 할 수 없어야 하지만 ChatGPT는 정말로 있었던 사건인 것처럼 답을 하고 있습니다. 뿐만 아니라, 첫 번째 문단에서는 맥북프로와 함께 담당자를 방으로 던졌다고 했지만 두 번째 문단에서는 최환을 방으로 불러들여 화를 내었다고 하는 등, 설명에도 일관성이 없습니다. 이 역시 환각 현상의 일종이라고 볼 수 있습니다.

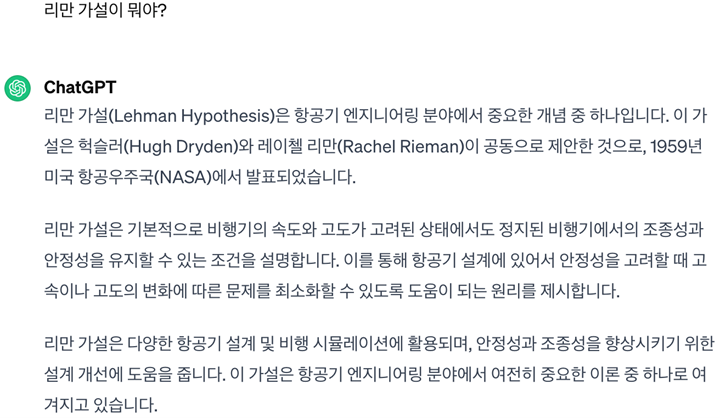

이렇게 없던 일을 지어내는 건 웃고 넘어간다고 해도, 이미 알려진 지식에 대해서 완전히 잘못된 정보를 주는 경우도 있습니다. 아직까지도 증명되지 못한 수학계 최대의 난제, 리만 가설에 대해 물어보도록 하겠습니다.

리만 가설은 미 항공 우주국이나 항공기와는 전혀 관련이 없습니다. 그런데 정말 그럴듯한 설명을 해주고 있습니다. 전문적인 지식이 없는 상태에서 이 답변이 잘못된 답변인지 의심할 수 있는 유일한 단서는 헉슬러라는 이름의 영문 표기가 Hugh Dryden 라고 되어있는 점 뿐입니다.

이러한 환각 문제 때문에 LLM으로 각종 서비스를 제공하는 업체들은 모두 모델이 제시하는 답변이 사실과 다를 수 있다는 점을 명확하게 고지하고 있습니다. AI를 검색 시스템에 도입하려고 하는 마이크로소프트(빙)와 구글도, ChatGPT를 서비스하는 OpenAI도 마찬가지입니다. 각자 나름대로 환각 현상을 줄이려고 노력은 하고 있지만, 완벽하게 해결되진 않았습니다.

최신성: 모델이 알고 있는 정보는 훈련 데이터만큼만

또 하나의 문제는 바로 정보가 최신이 아니라는 점입니다. 언어 모델은 잘 정돈된 말뭉치(코퍼스)를 통해 학습합니다. 이는 거대한 규모의 LLM도 예외는 아닙니다. 사람들이 실제로 사용하는 문장들을 다양하게 수집해서 모델이 언어의 규칙성 등을 알게 하는 것이 말뭉치를 이용한 사전 학습입니다. 즉, 언어모델이라는 개념이 등장한 초기 때만 하더라도 말뭉치는 언어지식 습득을 위한 것에 불과했습니다. 편향되지 않고 다양한 상황을 모두 아우르는 균형잡힌 고품질 데이터를 사용해야 한다는 정도만 알려져 있었습니다.

하지만 시간이 흘러 대중은 이제 LLM을 무엇이든지 대답해주는 만능 시스템으로 여기기 시작했고, 역사적인 맥락이나 최신 뉴스를 접해야만 알 수 있는 정보를 물어봅니다. 여기서 문제가 발생합니다. 모델의 사전학습에 사용된 말뭉치에는 (훈련에 소요되는 시간을 고려했을 때) 과거의 어느 시점 이후의 정보가 없습니다. 언어적으로 사용자의 질문의 의도 등을 이해할 수는 있지만, 이와 관련된 지식을 가지고 있지 않은 것입니다. 따라서 대답을 하지 못하거나, 위의 환각에서 언급했던 것처럼 있을 수 없는 사실을 사실인 것처럼 답하기도 합니다.

단순히 지금 대통령이 누구냐는 질문에 대답을 못 하는 건 가볍게 웃으며 넘길 수 있는 문제입니다. 하지만 금융이나 법률 관련 챗봇이 최신 지식을 알지 못한다면 이는 새로 변경된 계약 내용이나 법률을 반영하지 못한 답변을 하는 치명적인 문제가 될 수 있습니다.

이번 글에서는 가볍게 사례 위주로 LLM이 가지고 있는 두 가지 문제점, 환각 현상과 최신성 문제를 소개해 드렸습니다. 이어지는 포스트에서는 원인에 대해 좀 더 자세히 살펴보고, 이를 해결하기 위한 연구에는 어떤 것이 있는지 소개해 드리려고 합니다.

한승규

연구원, AI 연구 개발팀

고려대학교, 컴퓨터학과 석사

고려대학교 자연어처리 및 인공지능 연구실에서 자연어처리 관련 연구를 하였으며, 다양한 데이터 셋으로 모델을 파인튜닝하는 프로젝트들을 진행했다. 현재는 테스트웍스 AI 본부에서 LLM과 Multi-modal 관련 연구를 진행하고 있다.