최근 신기한 영상을 하나 발견했습니다.

햄버거 광고 영상이었는데 매장 내부를 마치 드론으로 촬영한 것처럼 카메라 경로가 매우 역동적이었습니다. 분명 실내에서 드론을 띄운다는 건 불가능한 것으로 알고 있었는데 이런 영상은 어떻게 촬영했을까요?

실내에서 어떻게 이런 영상을?

영상의 정체는 2D 영상 이미지를 토대로 3D 가상 공간을 만들어내는 인공지능 신기술 NeRF(Neural Radiance Field)를 활용한 광고 영상으로, 이제는 인공지능 기술을 활용한 제작물들이 TV에 나올 정도로 기술의 대중화가 이어지고 있습니다. 게다가 영상에서 보여주는 3D 공간은 지금까지 미디어에서 자주 보아왔던 뭉툭한 폴리곤의 3D 메타버스 공간과는 큰 차이를 보여주고 있습니다. 빛의 반사부터 물체의 질감까지 실물과 거의 유사한 형태로 만들어진 이 3D 공간은 인공지능 기술의 발전이 3D 공간 형성 분야에 얼마나 큰 진보를 가져왔는지 확연하게 깨닫게 해줍니다.

신기술 NeRF의 등장, 2D에서 3D로

테스트웍스는 단순히 2D 이미지 데이터 뿐만이 아닌, 다양한 3D 데이터 수집 및 가공 작업을 진행하고 있습니다. 이미 글로벌 기업에서 자사 보유의 LiDAR를 이용해 데이터 수집을 의뢰할 정도로 상당한 노하우를 축적해 왔는데요. 테스트웍스는 이를 기반으로 3D 데이터 구축 범위 확장을 통한 다양한 관련 시장으로의 진출을 목표로 하고 있습니다. 이런 와중에 큰 주목을 받고 있는 NeRF라는 새로운 3D 데이터 및 공간 생성 기술이 이목을 끌어 자세히 조사해 보았습니다.

이런 3D 공간 형성에 새로운 바람을 불러온 NeRF는 정확히 무엇일까요?

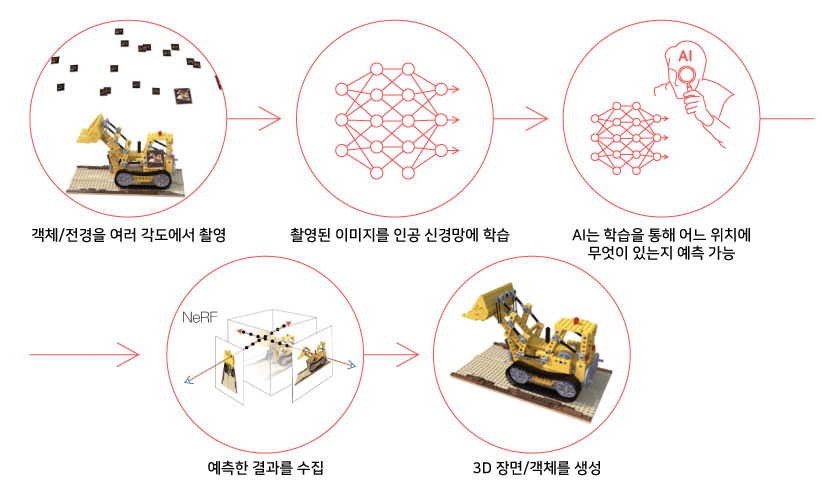

객체 사진을 여러 방향에서 촬영한다고 해도 필연적으로 모든 위치와 방향에서 물체를 바라본 사진을 전부 수집할 수는 없습니다. NeRF는 이런 문제를 해결하기 위해 연속적인 이미지 구성을 위한 새로운 시점에서의 이미지를 구성해 냅니다. 주어진 특정 시점에서의 이미지를 인공지능 신경망이 학습하여, 그 사이에 비어 있는 이미지들을 생성해 마치 물체를 3D로 보는 것과 같은, 전 방향에서 객체를 바라보는 것과 같은 결과를 이루어 냅니다.

“NeRF: Representing Scenes as Neural Radiance Fields for View Synthesis” 라는 제목의 논문이 2020년에 발표되면서 처음 세상에 등장하게 된 NeRF는 View Synthesis라는 과제를 해결하기 위해 등장했습니다. 객체를 여러 각도 및 위치에서 찍은 이미지를 이용해 새로운 시점(view)에서의 객체 이미지를 합성(synthesis)해 내는 과제를 위한 모델이 NeRF입니다.

NeRF의 기본 파이프라인. 주어진 드럼 사진을 이용해

중간에 비어 있는 시점에서의 드럼 이미지를 생성해낸다.

핵심만 요약해 보면 다음과 같습니다.

중요한 점은 이제 우리는 객체의 2D 이미지만 충분히 구할 수 있다면 NeRF를 이용해 이를 3D로 바꿀 수 있다는 것입니다.

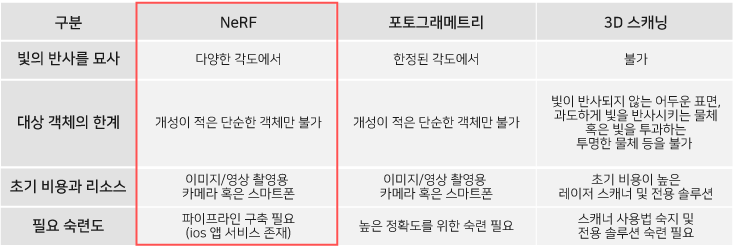

NeRF와 기존 기술과의 차별점

2D 이미지에서 3D 모델을 추출해내는 기술 자체는 이미 기존에도 존재했던 기술입니다. 포토그래메트리(Photogrammetry) 기법 혹은 3D 스캐닝을 이용한 3D 모델 생성 등은 여러 산업 현장에서 쓰이는 기술들이지만 NeRF는 이들과 몇 가지 근본적인 차별점이 존재합니다.

그 첫 번째는 기술의 이름 Neural Radiance Field에서 알 수 있다시피 훌륭한 빛 반사 재현입니다. 3D 스캐닝에는 레이저 혹은 특정 모양의 빛 반사를 이용하는 등에 여러가지 스캐닝 방식이 존재하지만 이들 모두 한 가지 치명적인 단점이 존재합니다. 빛을 반사하지 못하는 어두운 표면이나 과도하게 빛을 반사시키는 물체, 혹은 빛을 투과하는 투명한 물체 등은 스캐닝 하기 어렵다는 점입니다. 이럴 경우 물체에 무광 스프레이 등을 뿌리는 등의 조치를 취해야 하는 불편함이 존재하지만, NeRF의 경우 특정 시점에서 바라본 물체/전경의 빛 반사까지 고려하여 3D 공간을 만들어내기에 한정적인 대상에 그치지 않고 다양한 광경이나 객체를 3D화 할 수 있습니다.

NeRF로 촬영한 수영장. 물 표면의 빛 반사도 잡아내는 모습이다.

두 번째는 3D 공간을 만들어내는데 드는 초기 비용과 리소스가 굉장히 적다는 점입니다. 3D 스캐닝 방법 중 빛 반사, 혹은 레이저를 이용하는 스캐너의 기본 가격대는 최소 50 만원부터 시작하며, 높은 정밀성을 요구하는 산업용 스캐닝의 경우에는 전용 솔루션과 천 만원 대를 넘나드는 높은 정밀도의 스캐닝 기계가 필수입니다. 이런 부담스러운 투자 비용은 3D 기술을 소위 “찍먹” 해보고 싶은 사람들에게 초기 장벽으로 작용합니다. 그에 비하여 NeRF의 경우에는 필요한 초기 리소스가 단순히 사진 혹은 동영상을 촬영할 수 있는 기기(스마트폰, 카메라 등)로 가능하며, 필요하다면 NeRF 모델을 Google Colab 등으로 돌려서 큰 부담 없이 기술을 시연해 볼 수 있습니다.

마지막으로 NeRF는 다른 포토그래메트리나 3D 스캐닝이 요구하는 비교적 높은 숙련도가 필요하지 않다는 점입니다. 인풋으로 사용할 데이터 수집에 어려움이 사실상 없는 수준이기에 NeRF 모델을 돌리는 파이프라인 구축 이외에는 사전 작업이나 준비 혹은 스캐닝 노하우 같은 기술이 전혀 필요하지 않다는 점이 큰 장점으로 작용합니다.

요약하자면 다음과 같습니다.

점점 발전하고 있는 NeRF

NeRF가 세상에 처음 소개된 것이 벌써 3년전입니다만, 실제 유효한 기술로 각광받기 시작한 것은 비교적 최근입니다. 3년의 시간 동안 어떤 발전이 있었고 무엇이 NeRF가 연구자들에게 매력 있게 다가온 것인지 설명해보려 합니다.

처음 NeRF 논문이 나오고 많은 연구자들이 놀랐던 점은, 상대적으로 간단한 구조로 구성된 NeRF가 생각보다 훨씬 뛰어난 성능을 보여줬다는 점입니다. 인공지능 신경망을 학습시켜 3D 공간을 생성한다는 개념에서 출발하여 예상을 넘는 결과물을 도출해낸 NeRF는, 이 후 2021년과 2022년에만 주요 인공지능 학회(ICCV, CVPR)에서 NeRF 관련 논문이 50건 넘게 게제 될 정도로 많은 후속 논문을 촉발 시켰습니다. 기본적인 시작 점인 NeRF가 간단한 구조로 좋을 결과물이 나오니, 추가적인 구조의 변환, 혹은 fine tuning등의 조정을 거쳐 수많은 개선 점들이 도출되었고 이는 곧 편의성의 강화와 눈에 띄는 성능의 보완으로 이어졌습니다.

대표적인 예로 2020년에 처음 NeRF가 나왔을 때만 해도 인공지능 신경망을 학습시켜 간단한 물체를 3D로 구현하는데 최신식 그래픽카드로 21시간이 걸렸을 정도로 긴 학습시간이 요구되었습니다. 이는 2022년에 발표된 Plenoxel 이란 논문과, Nvidia에서 발표한 Instant NGP 라는 논문에서 각기 다른 방법으로 획기적인 학습 시간 단축을 불러일으키며 하루가 걸리던 학습이 불과 몇 분 단위로 단축되는 큰 발전을 이루었습니다.

NeRF와 Plenoxels의 학습시간 비교. 획기적으로 학습이 빠르다.

이러한 소요 시간의 큰 단축은 곧 NeRF에 대한 접근성의 향상과 단기간에 사용자가 원하는 3D 공간을 만들어주는 서비스 형식으로의 도약이 가능해졌다는 것입니다.

다음 글에서는 NeRF가 만들어내는 아웃풋에 관한 더 자세한 사항과, 현재 NeRF의 단점과 한계점, 그리고 이를 어떻게 극복해 나가고 있는가에 대하여 설명하겠습니다. 또한 색다른 NeRF의 발전 방향 소개와 현재 업계의 선두주자 소개로 찾아 뵙겠습니다.

김호중

연구원, AI 연구 개발팀

카네기멜론대학교 수학 학사

카네기멜론대학교에서 수학을 전공하며 프로그래밍을 이용한 다양한 응용수학 프로젝트를 경험하였다. 현재 테스트웍스 AI 연구 개발팀에서 Edge AI 및 Computer Vision, Object Detection 및 AI 모델 fine tuning 등의 업무를 담당하며 최근에는 3D 데이터, 특히 NeRF를 이용한 3차원 공간 생성 및 활용에 관한 연구를 진행하고 있다.