지난 1부에서는 NeRF라는 신기술에 대한 간단한 소개와 기존 기술들과의 차별점 및 빠른 발전 속도에 관하여 다뤄 보았습니다. 이번 글에서는 NeRF 기술의 부족함과 한계점, 이에 대한 극복 방안을 제시해 보려고 합니다. 그리고, NeRF의 여러 발전 방향에 대한 소개와 현재 NeRF의 주목도를 간단히 조명하며 마무리하겠습니다.

만능은 아닌 NeRF

앞서 1부에서는 NeRF가 기존 3D 스캐닝과 포토그래메트리아와 비교해 가지는 장점들에 대해 언급했지만, 아직까지 NeRF가 기존 기술들의 완벽한 대체제는 아닙니다. NeRF 기술에는 여러가지 부족한 점과 명확한 한계점이 존재하며, 이는 기술이 상용화 되는데 큰 장벽으로 작용하고 있습니다.

NeRF의 첫 번째 한계점은 대상 객체와 전경이 움직임이 없는 정적인 물체에 제한된다는 점입니다. 만약 NeRF로 3D 에셋화 하려는 물체가 촬영 중에 지속적인 움직임을 보인다면, 이는 곧 흐릿한 노이즈 형태로 3D 공간에 나타나게 됩니다. 이러한 한계점은 NeRF의 촬영 대상에 큰 제한으로 지속적인 움직임을 보이는 동물이나 물체, 실시간으로 바뀌는 음영이 포함된 광경 등을 NeRF로 만들 수 없는 단점으로 작용합니다.

NeRF가 가지는 또 다른 한계점은 아직까지 NeRF의 결과물인 Mesh나 Point Cloud 데이터에 대해 적절한 후처리가 필요하다는 점입니다. 3D 스캐닝의 경우에는 스캔된 물체 정보가 전용 솔루션에서 바로 뚜렷하게 시각화가 되지만, NeRF의 경우에는 부가적인 과정을 거치는 것이 필수입니다. 예를 들어, 촬영된 공간에서 어떠한 물체를 따로 잘라내어 객체화 할 것인지 명시하거나, 추출된 데이터를 Blender 같은 외부 3D 그래픽 툴을 사용하여 정제해야 합니다.

다행히 현재 테스트웍스는 NeRF로 생성된 Point Cloud 데이터를 섬세하게 가공할 수 있는 ‘blackolive 3D’ 툴을 보유하고 있으며, 이를 이용한 후처리를 통해 깨끗한 품질의 데이터를 확보할 수 있습니다. Point Cloud로 객체 및 전경 생성 시의 표면 밖으로 튀는 Point Cloud를 직접 지정하여 삭제할 수 있는 기능을 통해 데이터를 손쉽게 정제할 수 있습니다.

평평한 받침대 위에 마우스를 두었지만 3D 객체화를 하니 울퉁불퉁한 표면이 눈에 띈다.

마지막으로 언급할 NeRF의 한계점은 아직까지 만족스럽지 못한 학습 속도와 이에 맞물린 산출물 생성 시간입니다. 아무리 기존 20시간의 학습 속도를 10분 대로 줄였다고 해도, 즉각적인 결과물을 원하는 고객을 대상으로 10분 동안 마냥 화면만 바라보며 기다리게 하기는 어려운게 현실입니다. 현재까지 대중 보다는 연구자들과 아티스트들에게 어필하는 특성이 있는 NeRF가 정말로 보급화의 길을 걸으려면 실시간 학습을 시각적으로 보여주어 지루함을 달래거나 학습에 소요되는 시간을 5분 미만으로 줄이는 개선이 있어야 합니다. 적어도 희망적인 것은 NeRF의 발전속도를 보아 곧 실현될 수 있는 목표라고 생각됩니다.

NeRF의 한계 극복하기

앞에서도 언급한 것처럼 여러 한계에도 불구하고, NeRF가 희망적인 것은 발전 속도에 있습니다. NeRF는 실시간으로 논문이 쏟아져 나올 정도로 연구자들에게 주목 받고 있기 때문에, 앞서 말한 부족한 부분들을 극복하기 위해 어떤 연구들이 진행되고 있으며 어떠한 방향으로 발전하고 있는지 알아보겠습니다.

먼저 정적인 물체에 한해서만 NeRF가 가능하다는 한계를 극복하기 위해 많은 연구가 진행되고 있습니다. 가장 먼저 2020년도에 D-NeRF라는, 동적 객체에 대하여 시간 t 인자를 NeRF 학습에 추가로 넣어 각 시간 별 객체의 움직임을 재현하는 연구가 있었습니다. 하지만 잘 정제된 데이터 셋에 한해서만 어느 정도 성능이 나왔고 실용성이 떨어져 많은 후속 논문에서 인용되었지만 실제로 활용 가능한 수준까지는 도달하지 못했습니다.

최초의 시도였던 D-NeRF(Dynamic NeRF)는 추후 많은 후속 연구로 이어졌다.

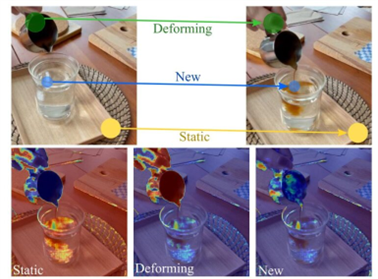

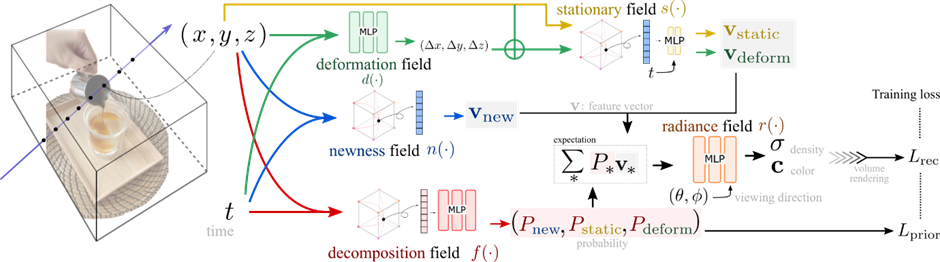

많은 후속 논문 중에서 소개해드릴 것은 NeRFPlayer라는 논문입니다. NeRFPlayer는 기존 논문들과 비교하여 무엇보다 가시적인 성과를 내놓아 주목을 받았습니다. 시공간을 정적인 부분 (Static), 새롭게 나타나거나 생성되는 부분 (New), 그리고 변형되는 부분 (Deforming)으로 각각 나누어 독립된 신경망에 학습시키는 방법을 채용한 이 논문은, 프레임 당 10초 정도의 학습 시간으로 과도한 시간 투자의 발생을 방지하였으며 무엇보다 결과물인 NeRF가 실제로 움직이는 객체를 잘 포착한 모습에서 많은 관심을 불러일으켰습니다.

출처 NeRFPlayer, February 18, 2023,

정적/신규/변형 세 가지 분류로 시공간을 나누어 각각 신경망에 학습시킨다.

NeRF로 만들어낸 산출물의 후처리가 필요하다는 점도 여러가지 방법으로 극복하려는 노력들이 진행 중에 있습니다.

학습한 NeRF 모델로 구현한 3D 객체/전경이 Unreal Engine이나 Blender 같은 3D 가공 툴에서 바로 후처리가 가능하도록 툴의 추가 기능으로 확장시키는 방식이 현재 도입되고 있으며, 좀 더 근본적으로 NeRF 모델을 활용해 만들어내는 3D 객체를 시각적으로 표현하는 Mesh의 퀄리티를 더욱 끌어올리려는 연구 또한 지속적으로 추진되고 있습니다.

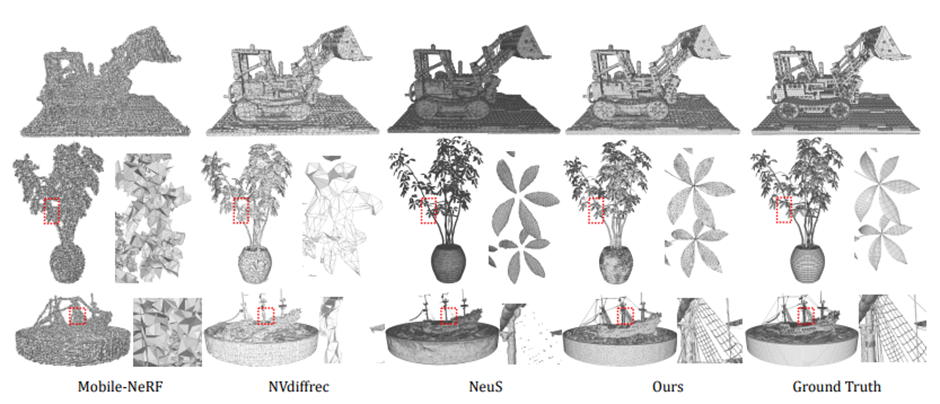

관련 연구 논문 중 하나인 NeRF2Mesh는 ‘adaptive surface refinement’를 이용해 생성되는 mesh의 퀄리티를 향상하며, 기존 방식들의 결과물 보다 더 좋은 아웃풋을 자랑했습니다. 이러한 mesh 퀄리티 향상 논문은 NeRF2Mesh에 국한되지 않고, 다양한 기법과 방법론을 채택한 후속 논문들로 계속 발표되고 있습니다.

Blender와 Unreal Engine에 NeRF를 접목시켜 사용감을 향상.

출처 nerf2mesh, March 03, 2023

최신 논문인 NeRF2Mesh가 비교적 더 좋은 퀄리티를 보여주고 있다.

NeRF의 발전 방향 예시

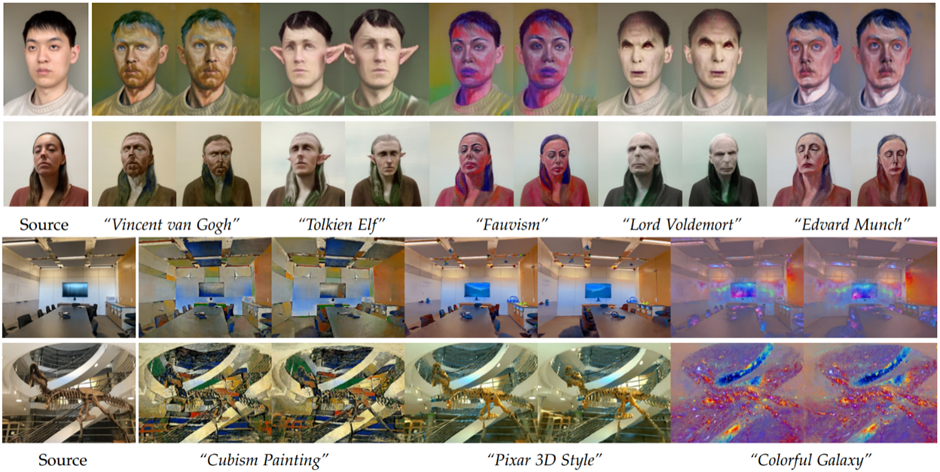

이러한 기술적 발전으로 인한 한계 극복 외에도 다양한 방향으로 NeRF는 발전하고 있습니다. 그 중 한 예시는 NeRF로 만들어낸 3D 공간을 특정 인풋 이미지의 색 배열로 바꾸거나 최근에 각광 받고 있는 생성 AI를 활용해 기초 형태는 비슷하지만 전혀 다른 내용과 느낌을 주는 연구입니다. NeRF-Art는 작년 12월에 발표된 논문으로, NeRF로 생성된 3D 객체/전경을 특정 키워드를 이용하여 기존 학습에 사용된 NeRF 모델 스타일을 변형하는 연구입니다.

비슷한 연구로 Ref-NPR은 기존 NeRF에 특정 스타일을 적용할 이미지 단 한 장을 사용하여 생성된 3D 공간을 통째로 스타일링 하는 연구로서, 위에 소개된 NeRF-Art 와 매우 비슷하지만 색다른 결과물을 보여주는 논문입니다.

마지막으로 Instruct-NeRF2NeRF라는 논문은 최신 생성 AI 기술인 InstructPix2Pix라는 논문에서 소개된 기술을 NeRF에 활용한 연구로, 앞서 소개된 방식인 키워드가 아닌 명령을 기반으로 NeRF 모델을 변형시킵니다. 모델 훈련 중에 사용되는 학습 이미지를 생성 AI에 명령을 적용시켜 뽑아낸 새로운 이미지로 교체하는 과정을 거쳐 기존 이미지의 형태는 유지하면서 새롭게 3D 객체/전경을 만들어냅니다.

3D 공간에 명령어를 입력하여 바꿔버리는 Instruct-NeRF2NeRF

NeRF에 대한 기대와 미래

지금까지 NeRF의 여러가지 장단점에 대하여 이야기하였지만, 실제로 NeRF가 미래를 대표할 신기술이 맞는지 의심을 쉽게 거둘 수 없는 것도 사실입니다. 메타버스는 아직까지도 크게 와닿지 않고 있으며, NFT 역시 그들만의 리그로 끝나는 분위기 속에서, 과연 NeRF에 가지는 기대감이 현실적인지 우려할 수밖에 없습니다. 그래도, 쉽게 단언할 수 없지만 우리는 테크 대기업들이 NeRF에 대하여 어떠한 판단을 내렸는지를 보며 유추할 수 있습니다.

우선 Meta가 NeRF에 대하여 어떻게 생각하는지 최근에 있었던 ‘Meta Connect Keynote 2022’에서 확인해볼 수 있습니다. 회사의 미래에 대하여 논의하고 소개하는 영상에서 CEO 마크 저커버그는 현재 연구하고 있는 NeRF를 언급하며, 간단한 영상 촬영을 통한 3D 객체 생성 데모와 함께 NeRF가 가지고 있는 잠재력과 추후 메타버스에서의 다양한 활용성에 주목했습니다.

또한 NeRF 기술의 진보에 큰 발전을 이바지한 NVIDIA 역시 최근 진행한 ‘NVIDA GTC 2023’에서 NeRF가 생성 AI와 맞물려 기존 3D 에셋 생성 과정의 단축화를 불러올 것이며, 3D 관련 업종에 큰 혁신을 불러올 것이라 소개했습니다. 무엇보다 현재 NeRF의 상용화에 선두를 달리고 있는 기업 ‘Luma AI’와 협업 및 투자를 발표하며 기술의 상용화와 대중화에 앞장서겠다는 포부를 밝혔습니다.

이렇듯, NeRF는 대중들에게 뜬구름 잡는 기술이 아닌, 상용화와 대중화가 매우 가까운 기술입니다. 많은 기업들이 앞으로 NeRF에 관심을 기울이며 기술의 진보가 가속될 것으로 예상되며, 기존의 기술들을 많이 대체할 것으로 예상됩니다. 이런 흐름속에서 테스트웍스 역시 신기술의 발전에 지속적으로 주목하며, 트렌드에 맞춰 NeRF가 어떠한 업무들을 대체할 수 있을지 고민할 것입니다.

테스트웍스는 NeRF의 발전을 지속적으로 주시하며 발 빠르게 트렌드를 따라갈 것이다.

김호중

연구원, AI 연구 개발팀

카네기멜론대학교 수학 학사

카네기멜론대학교에서 수학을 전공하며 프로그래밍을 이용한 다양한 응용수학 프로젝트를 경험하였다. 현재 테스트웍스 AI 연구 개발팀에서 Edge AI 및 Computer Vision, Object Detection 및 AI 모델 fine tuning 등의 업무를 담당하며 최근에는 3D 데이터, 특히 NeRF를 이용한 3차원 공간 생성 및 활용에 관한 연구를 진행하고 있다.